Nekem is a 7 ezres szériából való Radeonom van, igaz ez HD és 7850....

[Re:] [fLeSs:] Gondolatok a Radeon 7900-ról - BLOGOUT fórum

hozzászólások

Végre egy korrekt, objektív és független meglátás a helyzetről, maximálisan jól látod és minden ponttal egyet értek. Ebből is látszik, hogy milyen gigantikus veszteség érte a PH-t a távozásoddal. Ilyen emberkékre lenne szükség a PH-nak. Az AMD marketing osztálya valóban jól meglovagolta az RTX 4090-et, de sajnos rengetegen elvakultan látják a dolgokat, sokakat sikerült megvezetniük az átnevezéssel.

Skyline15

(tag)

Egyszerű a képlet (ahogy Barney mondta: az új mindig jobb - és a jobb közül most az AMD az "olcsóbb").

RTX3090 MSRP 1499$ volt

RTX4090 MSRP: 1599$.

RTX3080 MSRP: 699$

RTX4080 MSRP: 1199$

AMD flagship kártya MSRP:

7900XTX: 999$

Független tesztek után lehetünk okosabbak, de mindenki maga döntse el hogy mi a fontos.

Spekuláció: kit érdekel, hogy lemarad 20-25%-al 4090-től? Ha mondjuk 40%-al kevesebbe kerül?

Továbbá csati hiányában is 150W-al kevesebbet eszik?

Egyik kommentbe volt másik topic alatt kérdés, hogy miért nem lehetne mondjuk összevetni a két kártyát adott TDP keret limittel összehasonlítva, hogy mit tud? Ez lenne a legjobb teszt, de senki nem csinálja.

RX5500 vs RX6600 -nál nálam az ugrás ugyan azon TDP keret mellett (100W) volt 55% teljesítménybeli diff.

Volt nálam egy 3060 is, ott sajnos nem tudtam lockolni 100W-on a kártyát, de ezt a teljesítményt 3060-al 150W-ból hoztam ki, és teszt végére 5%-al gyorsabb volt, 170W-nál.

Lehet mondani, hogy Nvidia gyorsabb, sőt, mert gyorsabb is, de a kérdés, hogy megéri-e a fogyasztásbeli különbséget? Kinek mi számít persze.

[ Szerkesztve ]

Igazából a 4090-nel nem nagyon foglalkoztam itt az írásban, csak a chipméretek miatt hoztam fel.

Nem akarlak lelombozni, de az RTX 4090-hez az AMD-nek köze nincs, vagyis inkább még a kanyarban sincs hozzá képest.

Az 4090 azért ilyen drága mert:

1. ez az abszolút top jelenleg, a leggyorsabb mindenben ergó annyit kér érte az NV amennyit akar. Az AMD igazítja az árait az NV-hez, és nem fordítva

2. ez már inkább content creatoroknak szánt kártya, nem csak egy szimpla gamer kártya mint a Radeonok, aki pedig pénzt keres vele az megteheti, hogy kifizet érte $1600-at. Nézd meg mut tud Blenderben vagy Photoshopban (amihez pont felesleges) vs AMD

3. a 3000-es készletkisöprés is amellett szól, hogy drágán adják

4. a kínának gyártandó HPC chipek is amellett szólnak, hogy drágán adják vagy hogy egyáltalán ne is gyártsák és mesterségesen magas maradjon az ára a hiány miatt

Szal a 4090 nem "csak 20%-kal gyorsabb", hanem RT-ben sokkal gyorsabb és funkcionalitásban messze felülmúlja a Radeonokat.

Az AMD leragadt annál, hogy videokártya = játék. Az NV már jóideje úgy fejleszti a kártyáit/drivereket (amióta CUDA magoknak nevezi a stream processzorokat), hogy ne csak játszani lehessen a kártyáin.

Persze ha te egy szimpla játékos vagy és nincs szükséged ezekre a dolgokra akkor ott az AMD mint választási lehetőség.

Egyébként a kártya mint szó vmi olyasmit jelentene szvsz, hogy vmi vékony/lapos valami amit beledugsz valamibe...  mint pl. egy bankkártya.

mint pl. egy bankkártya.

Ezeket a sz@rokat már videotégláknak kéne hívni.

[ Szerkesztve ]

Gave

(addikt)

1) Nem úgy indul egy új széria, hogy az első 100-200 hsz a hashrateről szól

2) Értékelem a versenyt és a szándékot, de ezek nem normálisak

3) Túl sok a gyári tuning

4) Túl magas a TDP

4.1) Túl nagy hűtés kell

4.2) 10 éve kellene elfogadható sztenderd univerzális after market coolingnak

5) Megint drágább, és több a járulékos költsége

6) A hipsztertubetwitch kultúra nem segít

7) A szoftverek technical artja nem éppen a jó irányba halad

8) nem tudom mi lesz a következő, külön eATX box a VGAnak?

9) redukálhatnák a termék kat. visszatartást 5-6 hónapról 3-ra mondjuk, az is sok.

10) ha jól gondolom a Ray Tracing és a 1440p+ @ 60+ framerate egyelőre még luxus marad, ez majd kiderül a tesztekből.

Nem is nagyon van kedvem tovább menni, a 70/700-as végűek undervoltja remélem tudja majd a 2560x1440 => 3840x2160 felskálázást az újonnan megjelenő programokban is. Nem lenne rossz, ha a több VRAM opció lenne a közép kategóriában, aki esetleg valamiért mégis a hosszabb távú használatban bízna ( bár nem tudom miért tenne ilyet  )

)

ergoGnomik

(tag)

ez már a felhasznált szilikonból is látszik, az AMD 533 mm2 szilikont használ, az AD103 (RTX 4080) csak 379 mm2-t

Csak két aprócska megjegyzés:

1. szilikont egyetlen köbcentit sem használ egyik cég sem, integrált áramköröket gyártanak, nem műcs*cs*ket

2. érdekes a területek összehasonlítása, mert monolitikusat vetsz össze multicsip megoldással, 4nm osztályút 5/6nm osztályúval, szóval az NVIDIA megoldásból hiányoznak az csipek közötti összeköttetések áramkörei és előnyösebb gyártási geometrián készül – alma naranccsal?

Egyébként minek ezen ennyit rugózni. Az NVIDIA teljesítménye szokás szerint jobb, mint az AMD-é, pont. Kit érdekel, hogy mit próbálnak marketing mágiázni összevissza? Ne mondjátok már, hogy aki ilyet vásárol, annak pont a sok idióta reklám és fizetett teszt fogja megmondani mit vegyen vagy pont nem tesz magasról arra, hogy mi újság.

Szilikon alatt ugye minden esetben szilíciumot értesz. Jó a szilikon is csak másban

a vga kártyákban nincs szilikon.

a szó, amit kerestél: szilícium.

Skyline15

(tag)

Én még mindig azt mondom, meg kell várni a független teszteket.

Továbbá összekevered a dolgokat. AMD bemutatóján is pont ezt emelték ki, hogy ezek a kártyákat játékosoknak szánják, az hogy Nvidia elmegy professzionális szintre, hát menjen.

Mindenki azt fog venni amit akar, és ez most a játékosok piacára fog menni, Professzionális szintre ott vannak az RTX Axxxx kártyák vagy a W sorozatú AMD-k. Ennyi.

Két külön piac.

Én tartom magamat ahhoz, hogy sokat fogyaszt, és biztos hogy nem venném meg emiatt.

Jó lenne ha gyártók leállnának a 200W + -os dolgokkal, és energiahatékonyság fele mennénk el. Mert hamarosan egy fél blokkot kell lefoglalni Pakson, ha játszani akart egy i9 13900k + RX4090-el.

A szilikont átjavítottam szilíciumra, már hozzászoktam az angolhoz.

[ Szerkesztve ]

Shing

(őstag)

A nevezéktan nincs mindig szinkronban. pl. Az RX580 ment a GTX1060 ellen.

ergoGnomik

(tag)

A kérdés amit én feltennék, hogy a chiplet desingnak milyen előnye van a felhasználó számára?

Miért kellene bármilyen közvetlen előnyének vagy hasznának lenni a felhasználó számára akármilyen fizikai felépítésének? Különös tekintettel arra, hogy a felhasználó és a gyártó valójában ellenérdekelt felek.

A közvetettet meg ki tudod okoskodni te magad is 33 videó kártya után.

Dragbajnok

(tag)

Szuperül összefoglaltad!

Jó lenne ha visszajönnél az oldalra cikkírónak és teszternek!

Ezért az okfejtésért én mit kaptam az AMD találatósban. Köszönöm, hogy nem csak én láttam ezt meg ! De jó lenne nekünk ha még te is képviseltetnéd magad a PH-n.

Hasznos írás, elgondolkodtató és meggyőző is. No persze, fLeSs írta.

Azt nem értem, hogy mit szüttyög még mindig az AMD az RT teljesítménnyel. Jó eséllyel a Navi3x sem éri el az Ampere hatékonyságát. Talán csak a Turingét.

ergoGnomik

(tag)

Azt nem értem, hogy mit szüttyög még mindig az AMD az RT teljesítménnyel.

Adja magát háromféle lehetséges magyarázat is:

1) Ezek ennyit tudnak. Szóval adják ide a diplomáikat hogy eltéphessük és induljanak Kenyába banánt hajlítani! (Bár ezzel senki sem lesz beljebb.)

2) Egyszer régebben a fejlesztést pénzből máglyák rakásához és elégetéséhez hasonlítottam. Az AMD még mindig kisebb máglyát tud csak rakni, mint az NVIDIA és az Intel. Ebből csak akkor lesz pari vagy előny, ha az ellenfél botlik. Az NVIDIA nem botlik.

3) "Összeesküvés elmélet": sikerült valami esszenciális dolgot szabadalmaztatnia a zöldeknek és még nem jöttek rá a pirosak hogyan lehet anélkül is jó teljesítményt csiholni, vagy egyenértékű, de jogilag védhetően különböző megoldást összehozni.

Az RTX 4080 12gb-os verziójának esetében azért volt a felháborodás, mert az egy annyira megvágott kari, hogy azt jóindulattal egy RTX 4070(xy) karinak lehetett nevezni.

Azért az RX 7900XTX és 7900XT között nincsen akkora szakadék. Majd a 256bites memvezérlős kari lesz a 7800(xy).

Ezt próbáld meg elmagyarázni az AMD találgatósban a kollégának, aki szerint 4080 12GB/16GB és a 7900XT/XTX téma ugyanaz.

Chaser

(titán)

így van, semmi köze a 16-osnak a 12gb verzióhoz - aminél a kártyák neve egyértelműen azt sugalja, hogy csak a vram méretében térnek el, tehát minimum félrevezető -

illetve lett volna, ha nem offolják inkább

fless ezt jól összeszedted  , mindenben azért nem értek egyet

, mindenben azért nem értek egyet

Yutani

ha vkinek nem megy a spec összehasonlítása kérdezze meg kezelőorvosát és gyógyszerészét, bővebb kifejtésre az az összehasonlítás szerintem nem szorul

Magyarázd meg ezt egy zöld szemüvegesnek, aki szerint az AMD nem lehet kevésbé sáros, mint az NV.

Chaser

(titán)

ezen nincs mit magyarázni  és aki specekből nem tud matekozni azzal nem kell vitatkozni

és aki specekből nem tud matekozni azzal nem kell vitatkozni

meglepett amúgy hogy ennyire lemaradt most az amd, előző gennél azért kb hozták az nv csúcsot - 3090ti-t már nem tudom, de első körös 3090-ig biztosan -

mondjuk nagy veszteség nincs, a topot kevesen veszik, de azért naivan azt hittem ezzel a gennel is tudják tartani amit az előzőben

Ezen nincs mit magyarázni, az nV ezzel eléggé túllőtt a célon, amit az is bizonyít, hogy gyorsan visszakoztak.

Ugyanakkor jelen írás lényege szerintem, hogy néha marginális a különbség a két cég húzásai között, mégis sokan a nagy gonosz zöld nV és a jóságos piros AMD harcaként fogják fel, ami minimum méretes csúsztatás (és nyilván nem kis szerepe volt ebben Abu "objektív) cikkeinek is).

Annyit tennék hozzá, hogy az nV-re eleve ráégett egy csomó olyan dolog, ami nem is igaz (pl. hogy az első átnevezett vga az ő nevükhöz fűződik, pedig az Ati volt a tettes), vagy éppen ugyanúgy elmondható az AMD-ről is.

Hát aki nem látja, hogy az AMD is csak egy profitorientált cég, és a profit érdekében a marketing is be van vetve, azon nehéz segíteni.

Nagyon várom a 4070Ti/4080 és a 7900XT/XTX teszteket, hogy lássam a kártyák közti viszonyokat, természetesen a 4090-hez hasonlítva, aztán meglátjuk, mennyi az annyi.

paprobert

(senior tag)

"sikerült valami esszenciális dolgot szabadalmaztatnia a zöldeknek és még nem jöttek rá a pirosak hogyan lehet anélkül is jó teljesítményt csiholni, vagy egyenértékű, de jogilag védhetően különböző megoldást összehozni"

Az Intelnek, harmadikként érkezve, éveket csúszva, sikerült egy Nvidiához hasonló karakterisztikájú rélytrélyszinget hoznia az Xe-vel.

Nincs itt hiányzó AMD szabadalom, hanem spórolás, fillérb*szás van. A TMU-t "felokosítani" sokkal egyszerűbb mint egy komplex pipeline-t, dedikált hardvert, cache alrendszert kialakítani a GPU-n belül.

Gyorsan lefejleszthető, szilícium-takarékos, emiatt olcsó az AMD megoldása. Csak utólag betűztek egyetlen modult, és azt mondták, "kész!"...

[ Szerkesztve ]

ugyanaz a gpu, plusz probaljak meglovagolni a banyaszlaz veget, plusz normalizalni az 1000 usdhez kozelito GPU arakat.

ez max mehet par honapig, aztan ha kijon, hogy az inventory tenyleg rajuk ragad ennyiert, akkor majd normalizalodik a helyzet. anno 2019ben ugyanez volt.

a sub700 eur 6900XTk es 600 eur 6800XTk azert jol mutatjak a helyzetet.

[ Szerkesztve ]

Azért ne felejtsük el, hogy az NV egy generációval előrébb tart RT kártyákkal, szal ők már 2x dupláztak, az AMD-nek meg ez az első "duplázása" (bár az inkább max 80% lesz). Nem igazán lehetett elvárni hogy most hirtelen két generációt ugranak. Sztem ha lesz is AMD-nél vmi komoly akkor arra az RDNA4-nél van esély mondjuk egy Xilinx gyorsítóval, akkor még az is lehet, hogy lekörözik az NV-t.  és akkor majd büszkélkedhetnek a chipletjeikkel.

és akkor majd büszkélkedhetnek a chipletjeikkel.

Ha a 3-5 éves tervezési ciklust vesszük alapul akkor az RDNA3 tervezésének kezdetén még csak a Turing létezett ami elég lassúcska RT-ben, ahhoz képest az RDNA3 elég jó (lesz elvileg).

És ahogy írod, az NV-nél (és mint kiderült az Intelnél) ez az RT-támogatás elég sok tranzisztorba kerül, ehhez képest ha az AMD most elér egy RTX 3090 szintet RT-ben dedikált gyorsítók nélkül az durva eredmény.

Az NV (és az Intel) válaszott egy utat, gyorsak RT-ben, de a fogyasztásuk is olyan. Az AMD az egyre kisebb chipeket részesíti előnyben gazdasági és fogyasztási szempontok miatt. Az R&D büdzséjük sem volt meg hozzá eddig, ez idén már változik, ahogy elnéztem a negyedéves jelentésüket 1 év alatt kb. 80%-kal megugrott (2->3.6 milliárd $).

ergoGnomik

(tag)

Érdekes, hogy az "összeesküvés elmélet" címkéjű variáns volt az egyetlen, ami átütötte az ingerküszöbödet. Különösen, hogy egyikről sem állítottam miszerint igaz volna, csak hogy adják magukat.

Kövezz meg nyugodtan, de az a tény, hogy az Intel hasonlóképp hatékony megoldást tudott konstruálni a sugárkövetésre nem értem miért bizonyítja a feltételezett esszenciális szabadalom nem létét? Figyelem! Nem állítom, hogy létezik! (Lásd: "összeesküvés elmélet") Csak szerintem önmagában egy sikeres második implementáció nem mindent eldöntő ellenérv. Nem zárja ki másik megoldás lehetőségét. Nyilván nem tartom lehetetlennek, hogy a kékek konstrukciója pont ugyan úgy működik, mint a zöldeké, mert nem is próbáltam ennek utána járni. De önmagában csak a két létező megvalósítás logikailag nem zárja ki ezt a valószínűtlen lehetőséget.

A fillér szexualizálásos kijelentésed alapján gondolhatom, hogy a második említett lehetőséget nem tartod kizártnak? Vagy az (-z gonosz?) AMD (világot elemészteni kívánó?) céges mohósága fényében ez túl jóindulatú feltételezés lenne?

A TMU az a Texture Management Unit rövidítése? Hol tudnék arról olvasni, hogy ennek milyen kiterjesztésével lehet sugárkövetést megvalósítani GPU-kban? Sajnos nem vagyok képben a technikával, szóval rám férne némi tudás felszedése.

Mi a ló himbilimbit jelent a lefejleszt? Miért pont le? Régebben használtuk a fejleszt és kifejleszt szavakat, amik pont elegek voltak a tevékenység leírására. Mi változott a világban, hogy új igekötővel új szót kellett alkotni? Segítség! Segítség! Elmaradtam a valóságtól.

paprobert

(senior tag)

Az a baj, hogy az erőforrásokon való osztozás miatt van egy elméleti maximuma annak, hogy mit lehet kihozni az AMD konstrukciójából, ami mindig alacsonyabb mintha bele rakták volna a szükséges hardvert.

A CU "kéthengeressé" alakítása például nagy segítség volt az RDNA3-ban, mert szinte ingyen lesz az extra RT teljesítmény.

Attól függetlenül, hogy később lendült neki a piros csapat, a jövőt nem a kevesebb, hanem a több RT hardver jelenti.

Eddig nem lépték meg, mert valószínűleg túl sokat ártott volna a raszter sebességnek, és az árnak, és nem készült volna el a kiadási ciklusra.

De szerintem rövid időn belül elkerülhetetlen lesz, ha nem akarnak sereghajtók maradni.

#30 ergoGnomik

Abu85 nagyon részletes hardver-mélylélektanba ment bele az RDNA2 megjelenésekor, érdemes elolvasni itt a PH-n.

A zöld és a kék cég hardvere az RT munkafolyamat több szakaszát gyorsítja, és kevésbé van ráutalva a raszter pipeline sebességére.

Ez a mostani extra RT teljesítmény arra elég, hogy a 7900 XTX talán hozza a 3080 Ti RT teljesítményét (az eddig rendelkezésre álló adatok alapján). Tehát nem lesz meg ebben a körben sem a csúcs Ampere RT-ben, és onnan igen távol van még az Ada.

"lefejleszt" - ezt azért használjuk, mert a "fejleszt" az magát a folyamatot jelöli, míg ez annak befejezettségét. A "kifejleszt" esetén van egy hangulati különbség, mert abban azt érzem, hogy valami új készült, a többiben nem. De van még "felfejleszt" változat is...

Szerk: és egy igekötő nagyon sok új jelentést adhat, ezzel is bővülnek a nyelvi lehetőségek: nem mindegy például hogy valaki megsajnál vagy lesajnál téged.

[ Szerkesztve ]

nem mindegy például hogy valaki megsajnál vagy lesajnál téged.

Arról nem is beszélve, hogy lecsinál vagy felcsinál... ![;]](/dl/s/v1.gif)

ergoGnomik

(tag)

Az elég nagy kár, mert a lefejleszt pont ugyan úgy egy ige, mint a fejleszt. Nyelvtanilag szerintem meglehetősen nehezen tud eltérő funkciót betölteni a kettő. Ha befejezettséget akarsz jelölni, akkor szépen múlt időbe teszed vagy befejezett melléknévi igenévvé ragozod: fejlesztett. Pl.: A projekthez fejlesztett API jelentős teljesítménybeli előnyöket biztosít a korábbi megoldáshoz képest. Vagy: A csapat a rendelkezésre álló szűk idő alatt, áldozatos munkával fejlesztett egy alapjaitól új applikációt a megrendelő területi képviselői munkájának támogatására.

Tudom hogyan működnek az igekötők. Itt pont semmi érthető jelentéstartalmi bővülést nem érzek, csak azt, hogy valakik már megint nem tudnak magyarul beszélni.*  Különösen a felfejleszt fényében. Hacsak nem az ilyenkor a mondanivaló, hogy volt már valamink, de azt túl jónak gondoltuk, így szétgrimboltuk kicsit, hogy rosszabb legyen.

Különösen a felfejleszt fényében. Hacsak nem az ilyenkor a mondanivaló, hogy volt már valamink, de azt túl jónak gondoltuk, így szétgrimboltuk kicsit, hogy rosszabb legyen.

* Igen, a nyelv nem egy gránitba vésett állandó képződmény, hanem a használói igényeinek megfelelően változó, fejlődő organikus entitás. Azonban azt nem kellene hagyni, hogy az internet fél bites népe és további hasonszőrűen igénytelen egyének és közösségek mutassák a fejlődés irányát!

DigitXT

(félisten)

volt már valamink, de azt túl jónak gondoltuk, így szétgrimboltuk kicsit, hogy rosszabb legyen

A szó, ami ide passzol, a visszafejleszt, és abban nagyon jók vagyunk...

Ahogy a mondás tartja, egy lépés előre, két lépés vissza: lényeg, hogy haladtunk.

Ui: a Firefox értetlenül áll a szétgrimboltuk láttán. Grimbolni se tud, hát még szét.

[ Szerkesztve ]

"érdekes a területek összehasonlítása, mert monolitikusat vetsz össze multicsip megoldással"

Inkább fals, nem pedig érdekes. Nem lehet a chipletes és a monolitikus chipek költségeit ilyen egyszerűen összehasonlítani.

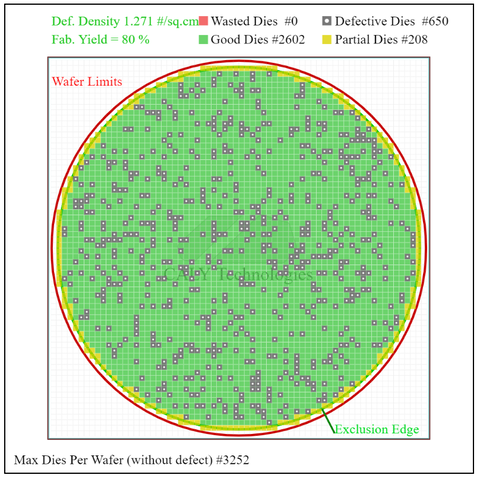

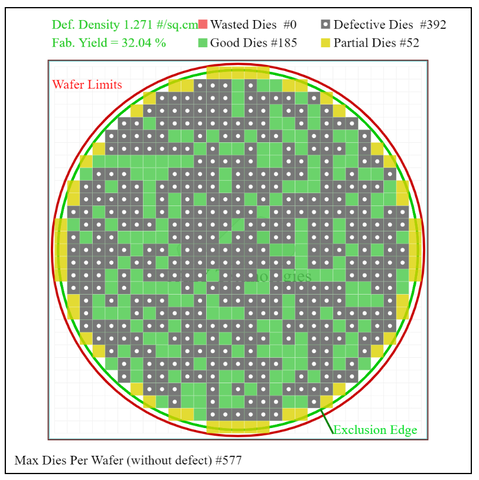

Kisebb lapkáknál (chipletek) a gyártás során egyetlen szilíciumostya megmunkálásánál jelentkező különféle hibák kevésbé befolyásolják az abból kinyerhető komplett, funkcionális lapkák felhasználhatóságát, vagyis kedvezőbb a selejtarány. Ez a bérgyártásban jellemzően ostyánkénti árazásnál alacsonyabb lapkánkénti költséget eredményez:

Cserébe a kisebb lakpkákat a tokozáson össze kell "drótozni", ami az egyes lapkákban extra áramköröket (interconnect) és komplexebb szubtrátumot jelent.

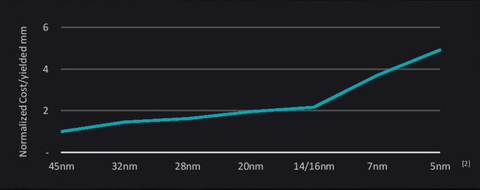

Az AMD szerint utóbbi vállalható a meredeken növekvő wafer költségek mellett, a rugalmasabb és gazdaságosabb termelés felülírja a különféle kompromisszumokat.

[ Szerkesztve ]

A felhasznált szilicium-terület összehasonlításával a teljesítmény per chipösszméretre (legyen T/C) utaltam.

Ha a 7900 XTX-t ezzel a T/C mutatóval a 4800 ellen tervezték volna eredetileg, akkor nagy lenne a gond (Vega vs 1080?). De nem az ellen tervezték ellentétben azzal amit az AMD mond.

Egyébként nagyon úgy tűnik, hogy raszterben a 4080 és 4090 között lesz, RT-ben meg 3080-3090 körül.

Az, hogy az AMD GCD-je kisebb, mint az NV GPU-ja és emiatt olcsó gyártani stb. addig nem tud érdekelni, amíg én ebből nem érzek semmit. Ez az AMD-nek jó, de nem nekünk, mégis nagy forradalmi előrelépésként adják elő sztem azért, mert nincs más a tarsolyukban. Egyrészt nem adják olcsóbban a cuccot, a fogyasztása azonos teljesítményszinten kb. ugyanolyan lesz mint a 4090-é (a 4090 350W-on hajtva 5%-ot veszít a teljesítményéből), és melegedésben is elég nehéz lesz lepipálni a 4090-et ami ~70C körül van terhelve (bár azzal a téglaméretű hűtőbordával ez nem is csoda).

Ha majd kijönnek egy olyan VGA-val, amin két GCD összedolgozik és az oprendszer egynek látja őket, akkor meghajlok (márha emiatt jó lesz az ára is). Az AMD mindig innovált régen is, elsők voltak többféle node-on, különböző DX verziók támogatásával, ilyen-olyan architektúrákkal, most éppen a DP2.1-gyel, ami a kutyát nem érdekel, mégis, a piaci részesedésük 20% és az emberek többsége nem is hallott róluk (ne a geek-ekből induljunk ki).

Vmi olyat tegyenek le az asztalra, ami a felhasználók számára ellenállhatatlan. Tőlem erőltethetik a chipleteket, is de akkor vegyenek vissza a profitból és adják olyan áron a kártyákat, hogy az NV-nek ne legyen esélye. Vagy szoftverben előzzék be az NV-t (nem a driverre gondolok). Vagy rakjanak RT-gyorsítót a kártyájukra. Vagy csábítsák át Jensen Huangot hogy ő legyen a PR részleg vezetője. Vmivel le kéne gyakniuk az NV-t hogy az emberek felfigyeljenek, és ez a valami nem a chiplet lesz amikor az átlag COD-os azt se tudja mi az a tranzisztor, nem hogy a chiplet.

[ Szerkesztve ]

Szerintem nem akarnak ők olyan nagyon piacot elvenni az NV-től, ezért nem is lesz egy újabb RV770.

"A felhasznált szilicium-terület összehasonlításával a teljesítmény per chipösszméretre (legyen T/C) utaltam."

Értettem. Erre írtam, hogy a chipletes megoldás (pláne ilyen kialakításban) növeli a területet az összekötésekhez szükséges extra áramkörök miatt, aminek ráadásul a teljesítményre semmilyen pozitív hatása nincs (sőt).

"Az, hogy az AMD GCD-je kisebb, mint az NV GPU-ja és emiatt olcsó gyártani stb. addig nem tud érdekelni, amíg én ebből nem érzek semmit. Ez az AMD-nek jó, de nem nekünk, mégis nagy forradalmi előrelépésként adják elő sztem azért, mert nincs más a tarsolyukban. "

Ha az XTX kb. a 4080 szintjét hozza majd az 200-300 dollárral alacsonyabb árával, az már szerintem eléggé érezhető lesz mindenki számára.

Az pedig nem új, hogy az innovációkat marketing célokra is megpróbálják felhasználni.

Az XTX a 6900 XT helyére lép be ami szintén $999 volt 2 éve és egy nagy chipre épül (persze ők úgy adják elő, hogy a 6950 XT helyére jön).

Szal ha a 7900 XTX most a chiplet miatt olyan jó üzlet az AMD-nek akkor adjon engedményt a kedves vásárlóknak. ![;]](/dl/s/v1.gif) Pláne ha tényleg be akarnak robbanni úgy mint a Ryzennel.

Pláne ha tényleg be akarnak robbanni úgy mint a Ryzennel.

Az NV árait nem érdemes figyelembe venni és ahhoz méricskélni, mert Jensen agya totál elborult ezekkel az árakkal, főleg a 4080 esetében, alig veszik azt a kártyát. A 3080-hoz képest +$500-ral hozakodott elő, teljesen bolond az ember. A 3080 $699-ért jött ki, vegyük úgy hogy most inflációval $799 lenne a 4080 normál ára, az AMD-nek ide kéne beáraznia a kártyákat, persze bolondok lennének ha $1000-ért is elviszik.

Az NV és az AMD karöltve egymással szépen emelgeti az árakat generációról generációra, pár év múlva egy 60-as kártya már $500 lesz. Lehet, hogy már a 4060 is megközelíti az $500-at.

Egyébként nézegettem a 7900 XTX specifikációit és azok alapján sztem az AMD által a slide-okon felvázolt alsó határt (50%) fogja inkább súrolni a gyorsulás.

shaders +20% (double pumped, az általában kb. annyit ér, mint CPU-knál az SMT ~+25-30%, tehát összesen ~+50%)

TMUs +20%

ROPs +50% (ez kellett)

RT cores +20% (...)

L0 és L1 cache +100% (ez RT-ben sokat segít)

L2 +50%

L3 kisebb de gyorsabb elérésű

memsávszél +84% (ez is kellett)

A Navi21 4K-ban lassabb volt az Amperehez képest mint 1080p/1440p-ben, szal a +ROP és +memsávszél az jól jön neki és ez a nagy "boost" talán tényleg felrepíti +70%-ra is majd egyes esetekben 4K-ban.

Összehasonításképpen a 4090 a 3090-hez képest

CUDA +52%

TMUs +52%

ROPs +57%

RT cores +52%

L1 +33% (ezért nincs szinte semmi gyorsulás RT-ben)

L2 1200%

memsávszél +zéró a Ti-hez képest

[ Szerkesztve ]

Szerintem egyértelmű, hogy a 4080 árait az Ampere miatt tartják fent, hisz az AIB partnereket kárpótolnia kell a bent ragadt készlet miatt meg nagy volt a háborgás hogy lecsökkentették az áraikat , volt is erről cikk nem rég itt. Amit így el tudnak adni az jó amit meg nem abból Ampere lesz. Január is lesz mire az RTX 7900XTX igazán kapható lesz szerintem, januárban majd bejelent egy árcsökkentést.

Most azt gondolom az RTx3000 szériát érdemes vásárolni amúgy is.

[ Szerkesztve ]

Most azt gondolom az RTx3000 szériát érdemes vásárolni.

inkabb semmit, hasznaltpiac eleg jol bearazta a helyzetet.

mondjuk 280 euro korul az RX6600 nem tunik rossz vetelnek es arra a 8GB ram is eleg.

[ Szerkesztve ]

RTx 3000 szériát használtan.  Én is azt vettem. Vannak garanciális példányok nagyon jó árban.

Én is azt vettem. Vannak garanciális példányok nagyon jó árban.

adatlapodon meg 2070et latok, mit sikerult behuzni?

Igen, tudom hogy a 3000-es készletkisöprés miatt (is) magas a 4080 ára, de ez a tények szempontjából már lényegtelen. Az AMD asszisztál az NV-nek, bár ők nem mennek $1000 fölé két okból sem. Egyrészt ebben a szegmensben már az ember megnézi mit vesz és az nem AMD lesz (a többségnél). Másrészt így pozitív fényben tudják magukat feltüntetni még így is, hogy valójában ők is túlárazták a kártyáikat, mert az NV még jobban túlárazta.

Összességében a 4080 normál piaci körülmények között jóindulattal max $799 kéne legyen, a 7900 XTX $849, a 7900 XT (átnevezett 7800 XT) pedig $700 (bár a teljesítményüket még nem is ismerjük...).

De ha az AMD fantasztikus chiplet megoldását és azt nézzük, hogy ők a 4080 ellen pozícionálják a kártyáikat akkor a le kéne vonniuk az árból további $100-150-et, erre azt lehetne mondani, hogy a chiplet marketing nem szimpla bs.

Már egy ideje másik konfig is van, csak nem írtam át, MSI 3080 12 GB Suprim X, jelenleg egy 12600K val hajtva 1440P ben.Jó kis kártya, nem sürget a csere.

[ Szerkesztve ]

Minden szavaddal egyetértek.

Ha úgy adódna- de persze ez bilibe a kéz esete- az ideális felállás az lenne hogy 4080- 799$,( sztem 999 lesz, ha lesz) 4080Ti -999$ ( 1199$ lesz) 4090-1399$( marad a mostani) 4090Ti -1599( 1999$)

Mondjuk szerintem érthető hogy megtették az első lépést AMD nél, de ha jól tudom ez még nem is igazán chiplet, MCM megoldás.

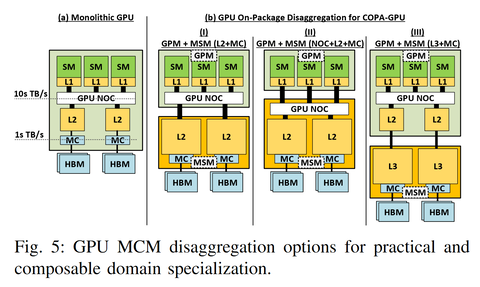

Nvidia így tervezi majd, COPA-nak hívják. [link]

Kísérleteznek melyik egységeket lenne jó késleltetés/ ár/ gyárthatóság szempontjából szétválasztani és melyeket egybe hagyni gondolom előszőr professzionális szegmensbe debütál, a HBM helyét átveszi a nagyobb gyorsítótár vagy behozzák azt amit már terveznek egy ideje hogy több féle Vram lesz egy kártyán akkor meg jöhet gamingba is.

Jensen azt nyilatkozta pár éve , mikor ez szóba került hogy az igazi MCM hez legalább( az akkori előrejelzésekből gondolkodva) 3 nm gyártástechnológia szükséges és megfelelő hőelvezetés.

[ Szerkesztve ]