Új hozzászólás Aktív témák

-

RobbyJr

őstag

Köszi szépen, jó kis teszt

Nincs lehetetlen, csak maximum Te nem akarod eléggé!

-

Érdemes még megemlíteni hogy a GT650 GDDR5 verziója átnevezősdivel GT1030-ként is piacra került a gpu hiány enyhítésére. [link]

Hivatalosan is az nvidia driverében GT1030-ként szerepel.

-

Dinomano

senior tag

Ha sok embert nem is, engem érdekelnek az ilyen cikkek, mivel érdekel a "beugró szintű" gaming, a gyengébb hardver kimaxolása, valamint az energiatakarékosság. :-)

/(^_^)____7=--- - - >|

-

brabbitz

aktív tag

Köszönöm szépen az irást, a tesztekkel együtt

Főleg mivel én AMD APU-val és az Intel iGPU-ról mindig levoltam maradva sajnos, nem tudtam róluk semmit igazán

-

Ha össznépi konszenzust keresünk, akkor bármilyen témáról eleve felesleges beszélni

A PC Masterrace tagjai kiesnek a potenciális APU-s közönségből, APU-n az gondolkodik, aki tényleges vizuális kompromisszumokat is el tud fogadni. Az 1080p + med sok játék esetében nem különbözik nagyon drámaian az 1080p + Ultrától, az 1080p + Low meg sokszor nem annyival gyorsabb, úgyhogy azért jó kitűzni a Mediumot targetnek. A felbontás csökkentésének sokkal láthatóbb hatása van a képminőségre.720p-ben tényleg kevesen játszottak, az 1366x768 volt a népszerű felbontás, csak a memóriám sikeresen összemosta a kettőt. Gépigény terén hasonlóak, annyit akartam mondani, hogy ebben a felbontásban anno a 3870k / 5800k nagyságrendileg hasonlóan muzsikált, mint most az 5700G 1080p-ben. Akkor még vállalható kompromisszum volt az alacsonyabb felbontás, ma már nem igazán az (ie. sokkal kevesebben vállalnák - nyilván van olyan, aki igen).

Ha pedig az AAA játékokat kivesszük a képből, akkor sokkal jobb az APU-k helyzete. Az 5700G-n még gondolkodtam is, csak aztán úgy voltam vele, hogy a franc fog venni Vegás chipet 2023-ban (meg amúgy sem kell nekem 8 CPU-mag), lássuk meg, mit tud az RDNA.

"We put all our politicians in prison as soon as they're elected." "Why?" "It saves time."

-

arty

veterán

a 265W-ot csak azért írtam, hogy csodák nincsenek, innentől pedig a kellő butítás lesz akinek "ó ez még tök oké" és van akinek "na ez a förtelem ez továbbra is azt mutatja hogy az APU-k alkalmatlanok játékra"

van akinek anno a 720p@low is elfogadható volt...

van akinek anno a 720p@low is elfogadható volt...

...és ma sem elég mindenkinek a 1080+med

mindenesetre szerintem 10 éve pécén nagyon kevesen játszottak 720p-ben, ellenben ma többen ragadtak 1080on, tehát az APU manapság nem akkora visszalépés (2023-as steam survey alapján 61% játszik 1080-ban, de a második legnépszerűbb felbontás 5+ százalékkal sem a 4k, hanem a 1360x768

)

)de ez most idilli állapot - nem csak az 5700G érdeme

még bőven jön sok játék a 2013-as generációs, akkor sem csucshardverű konzolokra.... (és persze switch és steamdeck is segít valamennyit, talán)

még bőven jön sok játék a 2013-as generációs, akkor sem csucshardverű konzolokra.... (és persze switch és steamdeck is segít valamennyit, talán)#73 Teasüti

köszi, sajna neked nagyon komplex a konfigod, hogy egyértelmű következtetéseket vonjunk le Fred23 3400G-je viszont azt igazolta, hogy bírja az AV1/4k/60/hdr-t.

Fred23 3400G-je viszont azt igazolta, hogy bírja az AV1/4k/60/hdr-t."ugyanitt hazájából elüldözött nigériai herceg aranybányájának tulajdonjogát megtestesítő NFT jegyezhető."

-

Teasüti

nagyúr

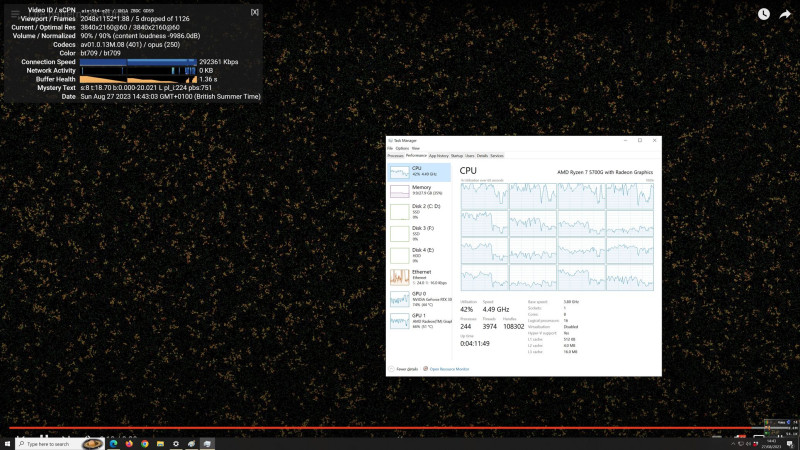

VP9 az hardveres. Azzal sose volt gond. (3D terheléseket ne nézd, az a két adapter közti jelenség).

Rendes AV1 videónál 4K@60-ig elég a processzor. 8K@60-nál már eldobálja a képkockákat. 8K@30 lehet menne még. De mire nekünk 8K-s monitorunk lesz, addigra ez a processzor már Bacsis kiállításán fog szerepelni.

Újra, a 3D terhelések nem mérvadók ebben a példában. Vmilyen okból abnormális terhelést ró a két adapterre az, hogy nem a megjelenítő hardver gyorsítja a böngészőt.

Újra, a 3D terhelések nem mérvadók ebben a példában. Vmilyen okból abnormális terhelést ró a két adapterre az, hogy nem a megjelenítő hardver gyorsítja a böngészőt.

A dekódolás szoftveres volt, nem használt a Vega 8 dekódert itt. -

-

Teasüti

nagyúr

A természetfilmes videót nézted, amit MasterDeeJay nézett a screenshot-on? Az nem akadozik, csupán maga a videó 24p-s és rövid záridővel készült a felvétel. Ezért tűnik darabosnak. A videós leszarta a 180 fokos zárszöget. Különben a mozgásfelbontás beesne ilyen 720p-re (motion blur-ből fakadó részletvesztés) és nem lehetne demózni vele a 8K-t.

![;]](//cdn.rios.hu/dl/s/v1.gif)

-

Ha a kacsa kötekszik, attól még nem a víz a hülye

Segítek kicsit: ha elkezded egy játékban lefelé kapcsolgatni a beállításokat Ultráról, akkor az első körben rengeteg FPS-t lehet nyerni nagyon limitált látványbeli veszteség mellett. Ezért hülyeség olyanokat pufogtatni, hogy 65W-ból nem jön ki 265W látvány - persze, hogy nem, de nem is ez a cél, hanem az, hogy a 265W-os látványból ne kelljen drasztikusan sokat engedni, megmaradjon a game eredeti karaktere és bizonyos fokig a szépsége. Az 1080p + Medium most valami ilyesmi - 10-12 éve meg a 720p + Medium volt hasonló. Szerintem az első APU-k hasonlóan birkóztak meg azzal a szinttel, mint most az 5700G az 1080p-vel.

RAM-sávszél: nekem nem fájna egy forrasztott megoldás sem, de mondjuk dual channel helyett quad channel memóriavezérléssel ezt jóval egyszerűbben meg lehet oldani. No meg az RDNA3-ban ott van az Infinity Cache is.

"We put all our politicians in prison as soon as they're elected." "Why?" "It saves time."

-

arty

veterán

"már majdnem "ott" vagyunk, már csak 1-2 év kérdése, hogy az APU-k alkalmasak legyenek ésszerű kompromusszumok mellett játékra"

ez az a mondat, aminek ZÉRÓ értelme

ha ezt most játékra, beállításra és számra kéne váltani, 10-en 10-félét írnánkszerintem az 5700G ma sokkal inkább ott van, mint 10 éve bármi (1080/med/30fps)

de pathtracelt cyberpunkra (mármint a 10 év mulva kijött 2088-ra értem) "sose" lesz APU, egyszerüen 65W CPUGPU-ból nem tud kijönni a 65+200wattnyi látvány... (és akkor a ramsávszél limitet még meg se említettük, mert gondolom lapra forrasztott fix 16-32-stb gigát senki nem akar)

(és akkor a ramsávszél limitet még meg se említettük, mert gondolom lapra forrasztott fix 16-32-stb gigát senki nem akar)"ugyanitt hazájából elüldözött nigériai herceg aranybányájának tulajdonjogát megtestesítő NFT jegyezhető."

-

Mehet az újabb könyvjelző a "for the ages" folderbe

Nagyszerű munka (mint mindig), nagyon alaposan tekinti át a megcélzott témát (mint mindig), és rengeteg információval szolgál további elemzésekhez (mint mindig). Első körben végigolvastam a cikket, és megnéztem az utóbbi 4-5 év APU-inak, IGP-inek az eredményeit, de a korábbi versenyzőkre is alaposabban rá fogok nézni.

Nagyszerű munka (mint mindig), nagyon alaposan tekinti át a megcélzott témát (mint mindig), és rengeteg információval szolgál további elemzésekhez (mint mindig). Első körben végigolvastam a cikket, és megnéztem az utóbbi 4-5 év APU-inak, IGP-inek az eredményeit, de a korábbi versenyzőkre is alaposabban rá fogok nézni.Egyelőre az 5700G és a két 4000G azt mutatja, hogy már majdnem "ott" vagyunk, már csak 1-2 év kérdése, hogy az APU-k alkalmasak legyenek ésszerű kompromusszumok mellett játékra - a probléma csak annyi, hogy immár majdnem 12 éve itt tartunk (ill. ha az 5700G-t vesszük jelennek, akkor 10 éve), és a helyből átugorhatónak tűnő 1-2 évet csak tolja maga előtt az ipar. Nagyon kíváncsi leszek egy RDNA-s APU-ra.

A diszkrét VGA-k kapcsán: a GT1030 és az RX550 nélkül félkarú óriás lenne a cikk, az APU-kat és az IGP-ket össze lehetne hasonlítani, de senkinek fogalma sem lenne, hogy viszonyul ez ahhoz a világhoz, amiről játéktesztek általában szólnak. A GTX 1630 és az RX 6400 a legutóbbiságuk folytán hasznos adatpont, de már korántsem annyira fontos, mint a másik kettő. Engem mondjuk a legkisebb mértékben sem zavarnak.

"We put all our politicians in prison as soon as they're elected." "Why?" "It saves time."

-

arty

veterán

ez baromi jó eredmény, köszi!

tehát akkor ahogyan a 3400G, úgy egy 4300G is "tökéletes" htpc apu lehet(nyilván fixfunkciós egységek lennének a legjobbak az ÉN szempontomból, de így is teljesen élhető az AV1 dekód...)

"ugyanitt hazájából elüldözött nigériai herceg aranybányájának tulajdonjogát megtestesítő NFT jegyezhető."

-

Proci terhelés 1%

alt+tab generál dropped frame-t

GPU media engine dolgozik, azaz hardveresen megy.

De mondom ez nem nagy szám mert pont ezzel reklámozták az inteles kártyákat hogy AV1-et tudja.

Másik gépben Rx560-ast próbáltam 0% GPU terhelés, hozzá se szagol. A proci meg megy 20-30%-on (Xeon 2687wv3), nincs sok dropped frame és nem is akad de nem jó ha a procit eszik meg.

[ Szerkesztve ]

-

arty

veterán

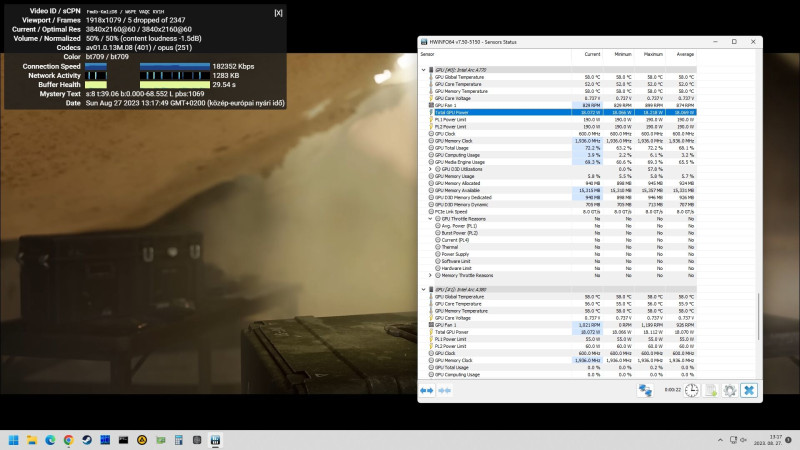

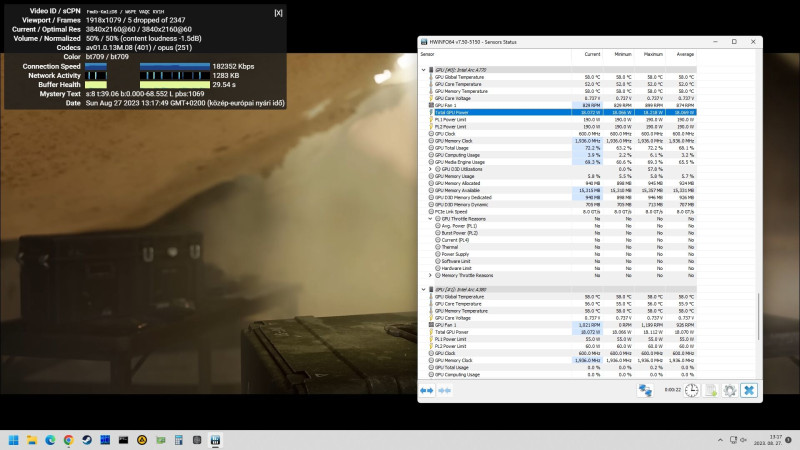

#53 MasterDeeJay

intelekről hallottam, hogy elég jó az AV1 hw dekódolási képességük... viszont volt már 2x intel alapu htpc-m és harmadszor nem dőlök be

htpc célra egy 4300G / GE elég lenne bőven, ha mondjuk megbírkózna egy 4k@60@hdr-es AV1-el ... persze ez sem kötelező, elvégre JELENLEG h264/h265 minden film (bluray, streaming, mkv), de a mostani htpc (llano A6-3600 + gtx950) is sok sok évre kellett, jó lenne picit előre menekülni és száműzni a dGPU-t újra...#56 Teasüti

a 6700xt 1-2% cpu terhelés mellett "3D-ből" megoldja a dekódot, de sajnos ezek a mérések mindenféle konfigon keveset segítenek, h a cél egy olcsó APU lenne

és pl ugyanez hdr tesztvideonál "már" 3-7% a ryzen5600ason... (3.6-4.0ghz-ig megy le az órajel, de ez idle-re is igaz, szóval ez "ilyen")

[link] - AV1, 4k60, HDR tesztvideo

tartok tőle, hogy a 4300G "3D" ereje ehez már kevés volna...#62 Fred23

megnézed kérlek a fenti 4k60-as HDR tesztvideot?

8k nem érdekel, remélem sose lesz olyan kijelzőm (utálok feleslegesen költeni)

"ugyanitt hazájából elüldözött nigériai herceg aranybányájának tulajdonjogát megtestesítő NFT jegyezhető."

-

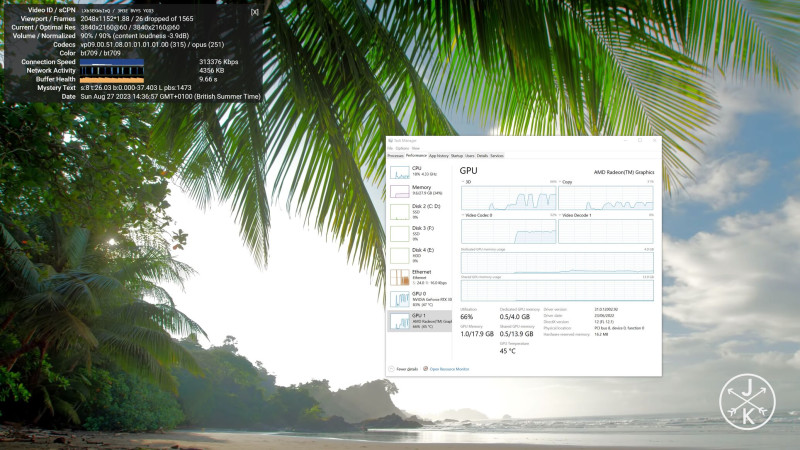

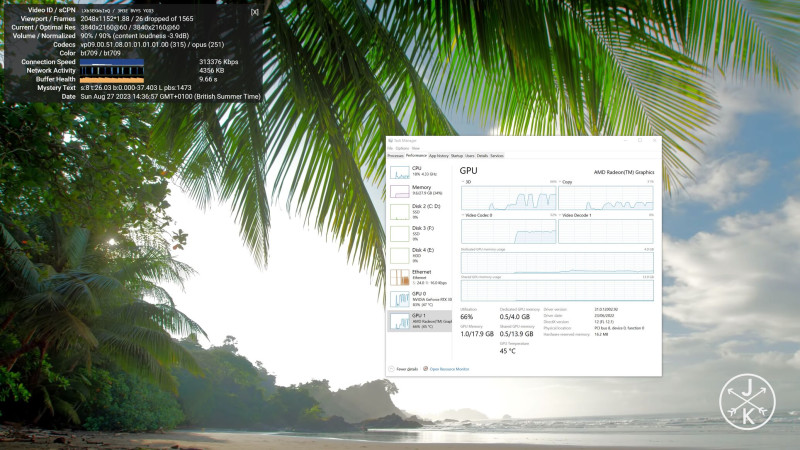

Csak próbaképp megnéztem ezt a videót amit linkeltél, a napi használós asztali gépemen (i7-9700 + 3070Ti).

A GPU terhelés a 3D részlegre 35% körül, a Video decode részlegre pedig 65% körül alakult, eközben 30W körül fogyasztott a GPU. CPU terhelés nem volt számottevő (10% alatt). Viszont maga a videó nem tűnt teljesen folyamatosnak, picid mintha akadt volna (de lehet ez összefügg azzal, hogy Full HD monitorom van, szóval vissza is kellett skáláznia a képet)

-

Teasüti

nagyúr

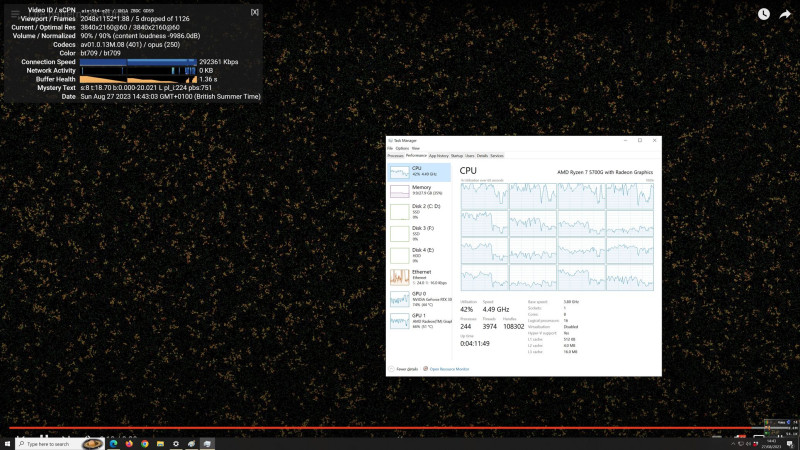

Érdekességképpen bekapcsoltam a Vega 8-at és néztem egy 8K AV1 videót YT-on, amit a kolléga is nézett feljebb. Windows Beállításokban csak átraktam az Edge-et iGPU-ra (Graphic Settings/Graphics Performance Preference) és megnéztem mit művel a Vega 8.

Hát, se videó dekóder, de általános számítás nem történt. Csak a 3D terhelés ugrott fel rajta - fura módon az a dVGA-n is durván megugrott. Lehet, ha kimenetet váltanék dVGA-ról iGPU-ra, akkor ez a jelenség megszűnne.Szóval magát a videót így a processzor számolta úgy 30% terhelésen az összes magon.

Eldobott képkocka nem volt. Szóval driver-es támogatás van AV1-re. Annyi, hogy szoftveres dekódolás történik.

Nekem, mint egyszerű fogyasztónak nem gondolom, hogy bármi hátrányom származna abból, hogy nincs hardveres AV1 dekódolás az 5700g-ben. Ez, hogy 10 Wattal kevesebbet fogyaszt a dVGA, mint a CPU 30%-on, ez olyan 1st world problem kb.

Gyakorlati jelentősége nincs igazán.

Hosszú hosszú évekig lehet fizetni a +10 Wattos villanyszámlát ezeknek a processzoroknak az árából, ha vkinek az AV1 hiánya deal breaker lenne.

[ Szerkesztve ]

Új hozzászólás Aktív témák

lo Avagy diavetítő bajnokság az alsóházban az integrált chipek házatáján, némi időutazás keretében.

- Iphone 12 128 GB kártyafüggtlen

- Asus Vivobook Go E1504GA-NJ146 /2026.01.02 gari/ 12gen. 8mag-8szál / 8gb RAM / 512 NVME/ WIN 11 PRO

- Acer Nitro ED320QR Full HD Ívelt 180HZ monitor

- P15s Gen2i 27% 15.6" FHD IPS i7-1165G7 T500 32GB 512GB NVMe magyar vbill ujjolv IR kam

- Latitude 7410 27% 14" FHD IPS i7-10610U 16GB 256GB NVMe ujjlolv gar

- Samsung 28" 4K W-LED U28E590D

- Lenovo Thinkpad T14 üzleti i5-10310u 10. gen. 16-32Gb RAM 256GB-2TB SSD, touch opció több db, gar.

- Iphone 12 128Gb black Vodafone 1,5 év gari 100% akku.

- Lenovo T14 Gen 1- 14.0" Magyar bill, Full HD, Intel Core i5-10210U, 16GB RAM, 256GB SSD, Win 10 Pro

- GIGABYTE Radeon RX 6600 XT 8GB OC GDDR6 128bit Hibás Videokártya

Állásajánlatok

Cég: Marketing Budget

Város: Budapest

)

)

![;]](http://cdn.rios.hu/dl/s/v1.gif)

(és akkor a ramsávszél limitet még meg se említettük, mert gondolom lapra forrasztott fix 16-32-stb gigát senki nem akar)

(és akkor a ramsávszél limitet még meg se említettük, mert gondolom lapra forrasztott fix 16-32-stb gigát senki nem akar)